近日,中国科学院空天信息创新研究院(空天院)王超研究团队在合成孔径雷达(SAR)图像智能解译与多模态基础模型领域取得新进展,提出了面向SAR数据的多模态对比预训练框架SARCLIP。

SAR具备全天时、全天候的成像能力,是对地观测的重要技术手段。然而,SAR影像存在散射噪声强、几何畸变复杂、缺乏语义标注等特点,限制了其在智能理解与大模型时代的应用。相比于光学影像,SAR领域长期缺乏具备通用语义理解与跨模态推理能力的基础模型。

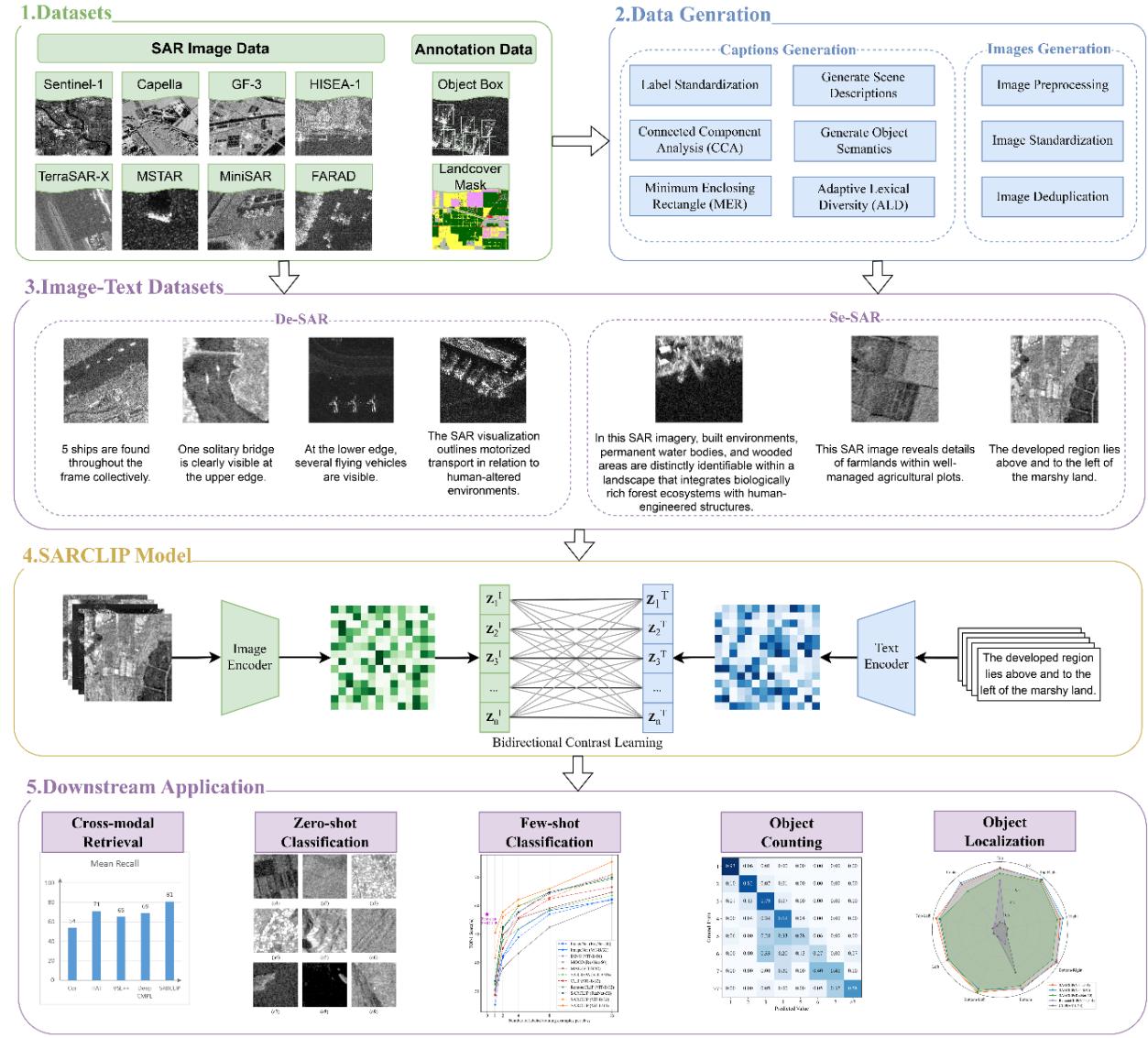

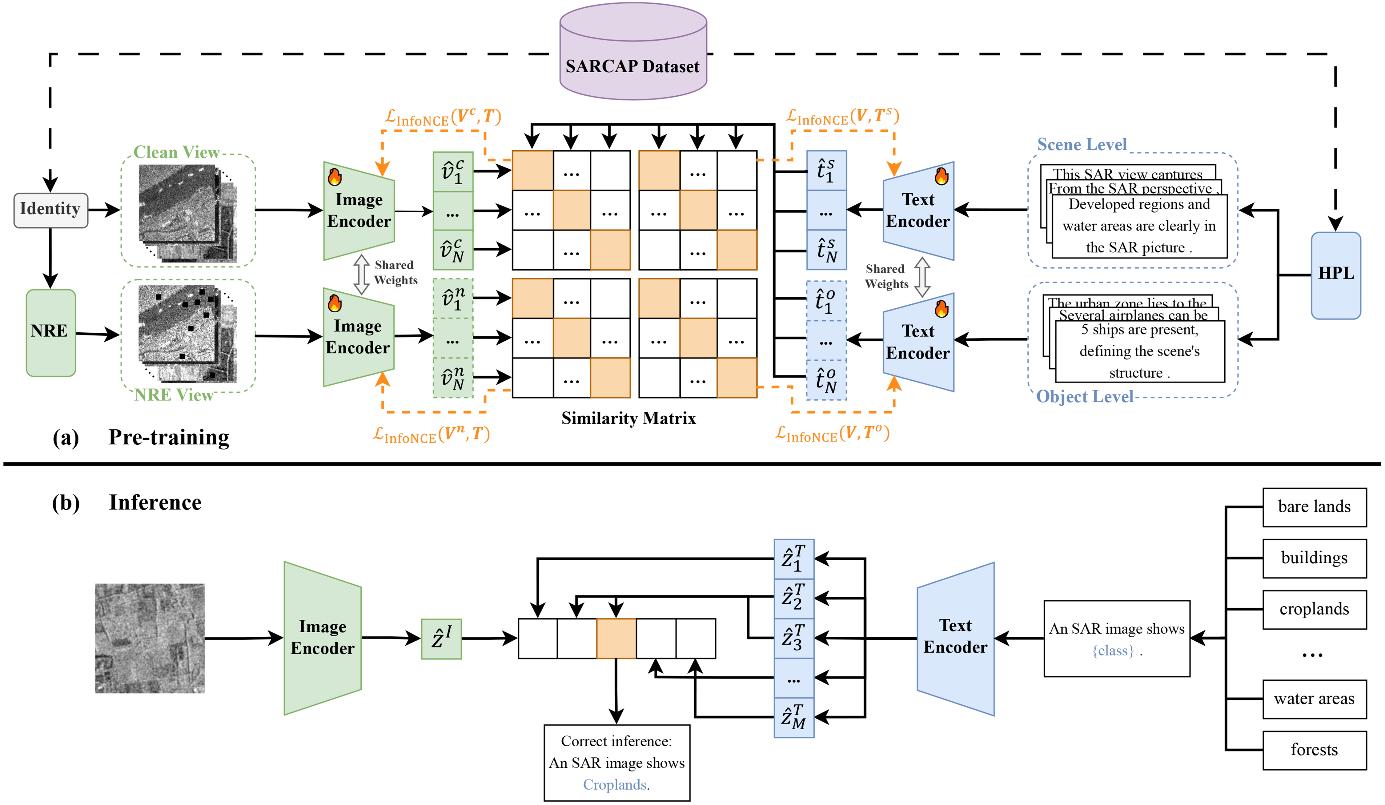

针对上述问题,研究团队提出SARCLIP框架,通过构建大规模SAR图文预训练数据集SARCAP(包含40万余对多分辨率、多传感器、多场景图文样本),实现SAR影像与自然语言语义的联合表征学习。为适应SAR数据特性,SARCLIP设计了两种SAR专属模块:噪声鲁棒编码模块(NRE)与分层文本引导模块(HPL),分别增强模型对物理扰动的稳定性与跨尺度语义对齐能力,从而显著提升SAR影像的语义理解和跨模态推理水平。

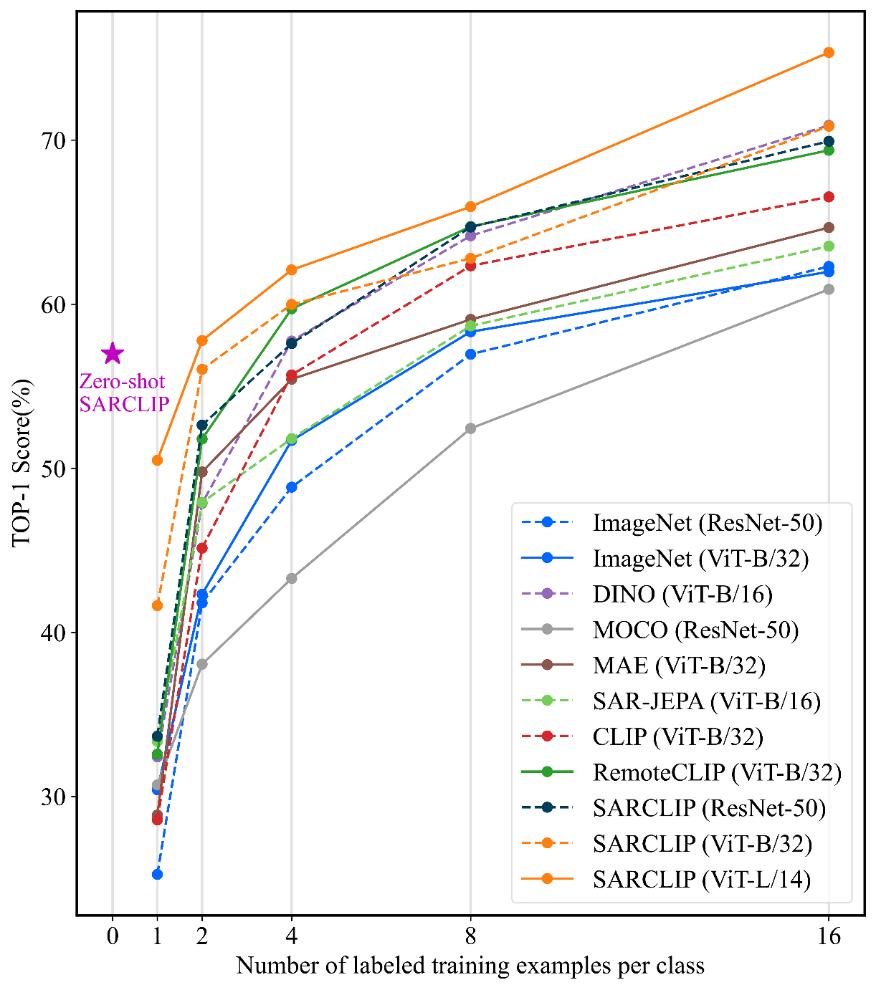

通过多个公开与基准数据集上进行的大量实验表明,SARCLIP在多项下游任务中均取得优异表现。在诸如跨模态检索、零样本和少样本分类、物体计数和物体定位等任务中,SARCLIP 一直能够取得与现有方法相当或更优的性能,这表明其在语义对齐、跨模态泛化与任务迁移方面均实现了显著提升,验证了其作为SAR领域多模态基础模型的先进性与实用价值。

上述研究成果以“SARCLIP: A Multimodal Foundation Framework for SAR Imagery via Contrastive Language-Image Pre-Training”为题,发表在遥感领域权威期刊《ISPRS Journal of Photogrammetry and Remote Sensing》(中国科学院一区TOP,IF=12.2)。该论文第一作者为空天院博士研究生蒋朝为,通讯作者为研究员王超。研究工作由国家自然科学基金委员会国家重大科学仪器研制项目和重点项目资助。

论文链接:

https://www.sciencedirect.com/science/article/pii/S0924271625004058

图1 SARCLIP 框架在数据收集、训练与下游应用中的整体概览

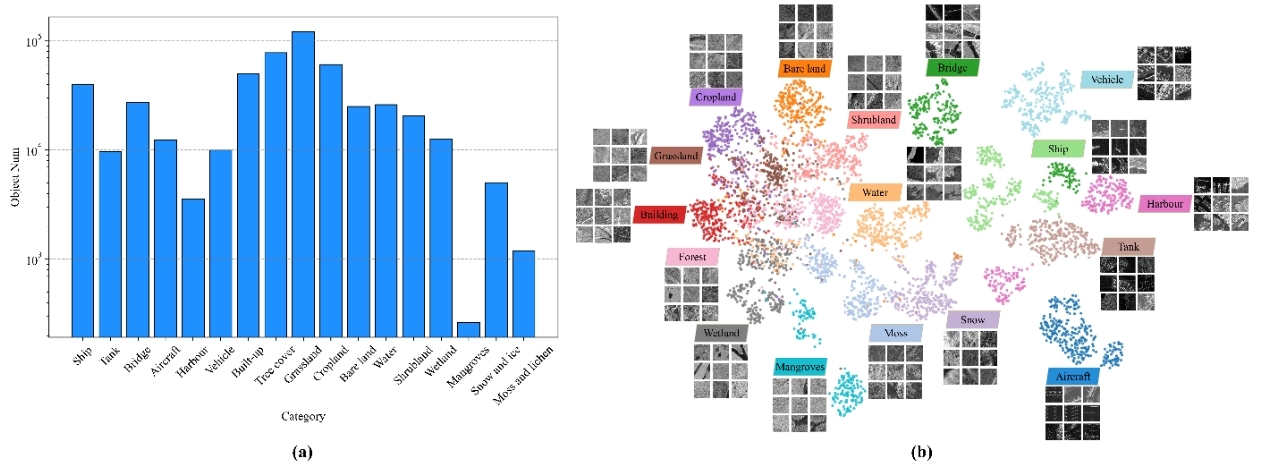

图2 SARCAP 数据集的分布与可视化结果。(a) SARCAP 各类别的样本数量分布。(b) 基于 UMAP 的降维可视化。每个类别随机选取 2,000 个样本进行展示。聚类的颜色与对应类别的文本标签颜色一致。每个标签附近展示的示例图像块为该类别中随机选取的样本

图3 SARCLIP 的 SAR 特定预训练与推理框架。(a) 预训练框架。(b) 推理框架

图4 不同训练样本数量下的小样本分类结果。曲线展示了 11 种不同模型在多种 SAR 数据集上的平均准确率变化趋势

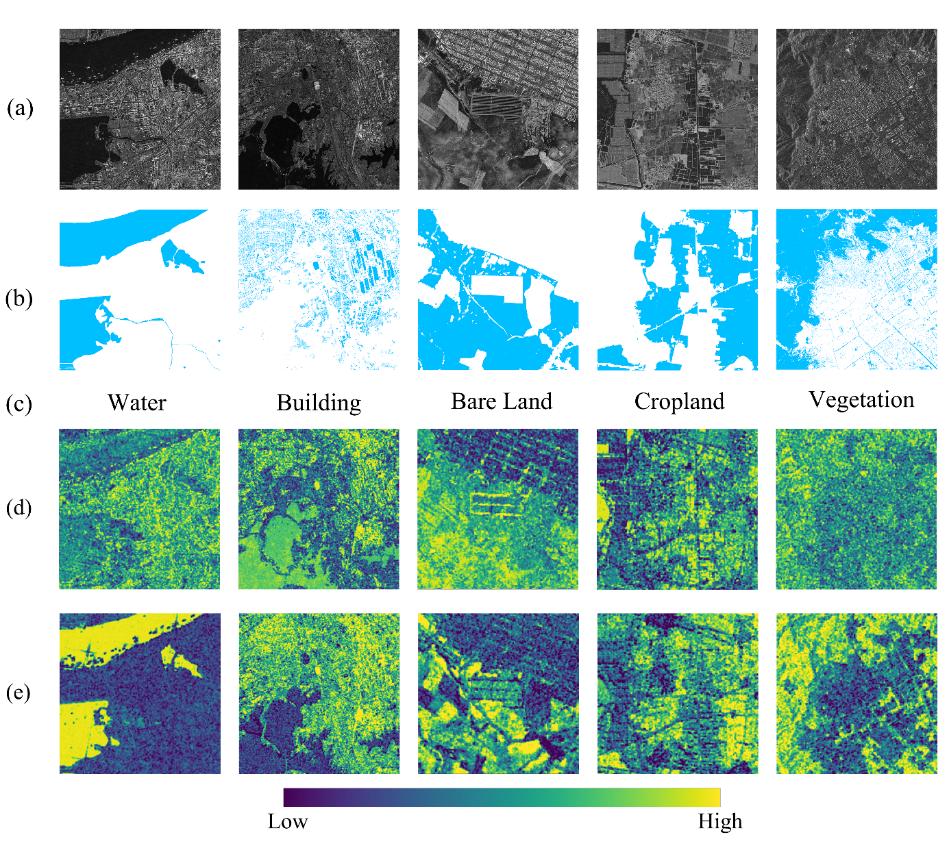

图5 消融实验中的图文相似度可视化结果。(a) 输入 SAR 图像,(b) 参考标签,(c) 文本提示,(d) 未使用 HPL 的 SARCLIP 相似度图,(e) 使用 HPL 的 SARCLIP 相似度图。颜色条表示相似度分数

动态新闻